La inteligencia artificial (IA) ha revolucionado la forma en que interactuamos con la tecnología y ha transformado muchos aspectos de nuestras vidas. Una de las áreas clave de la IA es el aprendizaje por refuerzo, que es el proceso mediante el cual una máquina aprende a través de la interacción con un entorno y la retroalimentación que recibe. En este contexto, LPPO (Learning from Human Preferences with Policy Optimization) es un enfoque de aprendizaje por refuerzo que utiliza las preferencias humanas para mejorar el rendimiento de los sistemas de IA.

Qué es un POC de IA

Antes de profundizar en LPPO, es importante entender qué es un POC (Prueba de Concepto) en el contexto de la IA. Un POC es una solución cerrada pero funcional que se puede evaluar y probar sujeto a criterios claros. En otras palabras, es una forma de probar una idea o concepto antes de implementarlo a gran escala. En el caso de la IA, los POC permiten a los desarrolladores y expertos tomar decisiones informadas sobre la viabilidad y el potencial de una solución.

Un POC de IA implica la implementación de un modelo de aprendizaje automático en un entorno controlado para demostrar su capacidad y efectividad. A través de un POC, los expertos pueden evaluar cómo funciona un modelo de IA en situaciones reales y qué tan bien se adapta a las necesidades del usuario final. Esto ayuda a identificar posibles problemas y ajustar el modelo antes de su implementación completa.

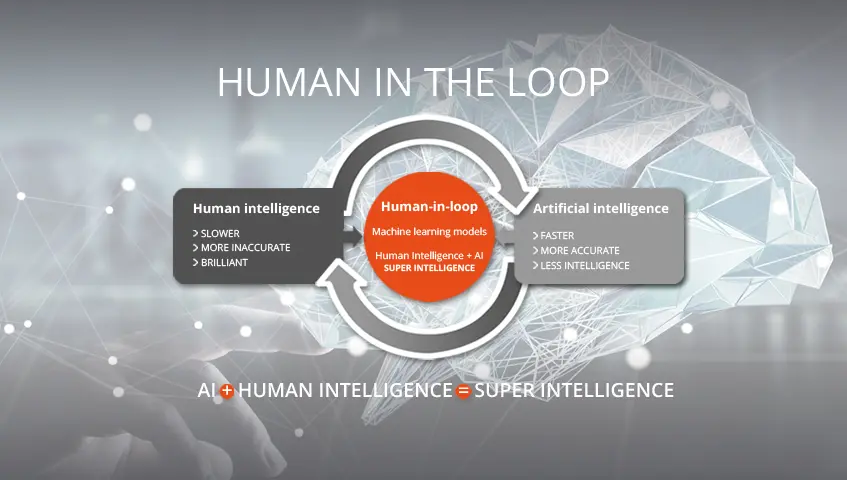

Qué significa Human-in-the-loop

El concepto de human-in-the-loop se refiere a la interacción entre los seres humanos y los sistemas de IA. En el contexto de LPPO, implica que los humanos proporcionan retroalimentación y preferencias que se utilizan para mejorar el rendimiento de los modelos de IA. En lugar de depender únicamente de algoritmos y datos, LPPO aprovecha el conocimiento y la experiencia humana para guiar el proceso de aprendizaje.

La idea detrás de human-in-the-loop es que los humanos pueden proporcionar información valiosa que los algoritmos por sí solos no pueden capturar. Esto es especialmente relevante en casos donde los datos son limitados o incompletos. Al incorporar las preferencias humanas, LPPO puede mejorar la capacidad del modelo de IA para tomar decisiones más acertadas y adaptarse a diferentes situaciones.

Beneficios de LPPO en la IA

LPPO ofrece varios beneficios en el campo de la IA. Algunos de ellos son:

- Mejor toma de decisiones: Al incorporar las preferencias humanas, los modelos de IA entrenados con LPPO pueden tomar decisiones más alineadas con las necesidades y preferencias de los usuarios finales.

- Mayor adaptabilidad: LPPO permite que los modelos de IA se adapten a diferentes situaciones y contextos, lo que los hace más flexibles y útiles en una variedad de escenarios.

- Reducción de sesgos: Al tener en cuenta las preferencias humanas, LPPO puede ayudar a reducir los sesgos inherentes a los modelos de IA, mejorando así la equidad y la imparcialidad.

- Mejor experiencia del usuario: Al utilizar LPPO, los sistemas de IA pueden proporcionar una experiencia más personalizada y satisfactoria para los usuarios finales, ya que se adaptan a sus preferencias individuales.

Consultas habituales sobre LPPO en la IA

¿Cómo se recopilan las preferencias humanas en LPPO?

Las preferencias humanas en LPPO se recopilan a través de diferentes métodos. Uno de ellos es la interacción directa con los usuarios finales, donde se les solicita que expresen sus preferencias en relación con diferentes opciones o situaciones. Otra forma es a través de la observación de las acciones y elecciones de los usuarios en un entorno controlado.

¿Es necesario tener conocimientos técnicos para utilizar LPPO?

Si bien tener conocimientos técnicos puede ser beneficioso para comprender mejor el proceso de LPPO, no es estrictamente necesario. LPPO se basa en la retroalimentación y las preferencias humanas, por lo que cualquier persona con conocimiento del dominio relevante puede contribuir a mejorar los modelos de IA utilizando este enfoque.

¿Cuáles son los desafíos de implementar LPPO en la IA?

La implementación de LPPO en la IA puede presentar algunos desafíos. Uno de ellos es la recopilación de preferencias humanas de manera efectiva y representativa. Además, la integración de estas preferencias en los modelos de IA puede requerir un diseño cuidadoso y una adaptación adecuada de los algoritmos existentes. También es importante considerar la ética y la privacidad al utilizar datos y preferencias humanas en el desarrollo de sistemas de IA.

¿Cuál es el futuro de LPPO en la IA?

LPPO tiene un gran potencial en el campo de la IA y se espera que desempeñe un papel cada vez más importante en el desarrollo de sistemas inteligentes. A medida que la tecnología avance y se perfeccionen los métodos de recopilación de preferencias humanas, es probable que LPPO se convierta en una parte integral del proceso de entrenamiento y mejora de los modelos de IA.

LPPO es un enfoque de aprendizaje por refuerzo que utiliza las preferencias humanas para mejorar el rendimiento de los sistemas de IA. Al incorporar las preferencias humanas, LPPO permite una mejor toma de decisiones, mayor adaptabilidad, reducción de sesgos y una experiencia del usuario más satisfactoria. Aunque presenta desafíos en su implementación, LPPO tiene un futuro prometedor en el campo de la IA y puede desempeñar un papel clave en el desarrollo de sistemas inteligentes.

Si quieres conocer otras notas parecidas a Aprendizaje por refuerzo con preferencias humanas: lppo en ia puedes visitar la categoría Inteligencia.