La inteligencia artificial (IA) se ha desarrollado durante décadas, pero el acceso limitado a grandes conjuntos de datos y la falta de arquitecturas informáticas adecuadas han limitado su avance, hasta hace poco.

La aparición del aprendizaje profundo, la nube, las arquitecturas informáticas paralelas y la carrera por capacidades de IA sofisticadas como el reconocimiento de voz, imagen, video y texto, han acelerado la investigación en IA. Esto ha impulsado una nueva ola de inversión en hardware de IA premium, capaz de acelerar el desarrollo de aplicaciones.

Uno de los componentes clave en la pila tecnológica para la inteligencia artificial, como el almacenamiento, la memoria, la lógica y la red, es el hardware de IA, que orquesta y coordina los cálculos entre los aceleradores, sirviendo como un diferenciador en IA.

Según estudios, la demanda de chips de IA y hardware específico de aplicaciones aumentará aproximadamente entre un 10 y un 15 por ciento, lo que resultará en un mercado de hardware de IA de $109 mil millones para 202Debido al crecimiento continuo en la disponibilidad de datos, la potencia de cálculo y el ecosistema de desarrolladores, los fabricantes de chips compiten por construir hardware de IA para capturar entre el 40 y el 50 por ciento del valor total de la pila tecnológica, lo cual es la mejor oportunidad que han tenido en décadas.

- Tipos de hardware de IA

- Por qué necesitamos chips de IA de vanguardia para la IA

- Resumen de las tecnologías relacionadas con los chips de IA

- Video/Imagen:

- Sonido y voz:

- NLP (Procesamiento de Lenguaje Natural):

- Control:

- Topología de redes neuronales:

- Redes neuronales profundas:

- Algoritmos de redes neuronales:

- Algoritmos de aprendizaje automático:

- Optimizaciones de rendimiento de chips:

- Chips neuromórficos:

- Chips programables:

- Arquitectura de sistema en chip:

- Herramientas de desarrollo:

- Memoria externa de alta velocidad:

- Interfaz de alta velocidad:

- Dispositivos biónicos (sinapsis artificiales, neuronas artificiales):

- Nuevos dispositivos de cómputo:

- Memoria en chip (matriz sináptica):

- Proceso CMOS:

- Apilamiento 3D CMOS:

- Nuevas tecnologías:

Tipos de hardware de IA

El hardware utilizado en IA actualmente principalmente consiste en uno o más de los siguientes:

- CPU - Unidades de Procesamiento Central

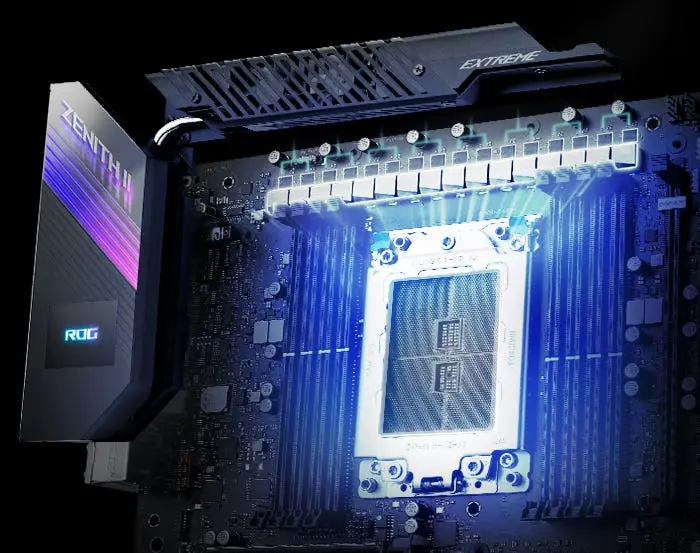

- GPU - Unidades de Procesamiento de Gráficos

- FPGA - Arrays de Puertas Programables en Campo

- ASIC - Circuitos Integrados Específicos de Aplicación

Las máquinas modernas combinan potentes CPUs multinúcleo para resolver el procesamiento paralelo con hardware dedicado. Las GPU y las FPGA son los componentes de hardware populares, dedicados y comúnmente utilizados en sistemas de IA desarrollados en estaciones de trabajo.

Una GPU es un chip diseñado para acelerar el procesamiento de datos multidimensionales, como una imagen. Una GPU está compuesta por miles de núcleos más pequeños, diseñados para trabajar de forma independiente en un subconjunto de datos de entrada que requiere un alto poder de cálculo. Las funciones repetitivas que se pueden aplicar a varias partes de la entrada, como mapeo de texturas, rotación de imágenes, traducción y filtrado, se realizan de manera más rápida y eficiente utilizando una GPU que tiene memoria dedicada.

Por otro lado, una FPGA es una lógica digital reconfigurable que contiene un conjunto de bloques lógicos programables y una jerarquía de interconexión reconfigurable. Una FPGA no es un procesador, por lo que no puede ejecutar un programa almacenado en memoria. Se utiliza un lenguaje de descripción de hardware (HDL) para configurar una FPGA, y a diferencia de la CPU tradicional, funciona de manera verdaderamente paralela. Esto significa que se asigna una sección dedicada del chip a cada tarea de procesamiento independiente, mientras que muchas partes del mismo programa pueden ejecutarse simultáneamente. Además, una FPGA típica puede tener bloques de memoria dedicados, administrador de reloj digital, bancos de E/S y varias otras funciones que varían según los modelos. Mientras que una GPU está diseñada para un rendimiento eficiente con hilos similares en diferentes subconjuntos de entrada, una FPGA está diseñada para el procesamiento secuencial en paralelo del mismo programa.

Al igual que todas las CPUs de propósito general, los chips de IA ganan velocidad y eficiencia al incorporar un gran número de transistores cada vez más pequeños que funcionan más rápido y consumen menos energía que los transistores más grandes. Pero a diferencia de las CPUs, los chips de IA tienen otras características de diseño que también están optimizadas para IA. Estas características aceleran drásticamente los cálculos idénticos, predecibles e independientes que requieren los algoritmos de IA. Incluyen:

- Realizar un gran número de cálculos en paralelo en lugar de en secuencia

- Calcular números de baja precisión de manera que implementen con éxito los algoritmos de IA pero reduzcan el número de transistores necesarios para el mismo cálculo

- Acelerar el acceso a la memoria almacenando todo el algoritmo de IA en un solo chip de IA

- Utilizar lenguajes de programación especialmente diseñados para traducir de manera efectiva el código informático de IA para su ejecución en un chip de IA

Diferentes tipos de chips de IA son útiles para diversas tareas. Las GPU se utilizan principalmente para el desarrollo inicial y la mejora de los algoritmos de IA, este proceso se conoce como entrenamiento. Las FPGA se utilizan principalmente para aplicar los algoritmos de IA entrenados a datos del entorno real, esto se conoce como inferencia. Los ASICs pueden diseñarse tanto para entrenamiento como para inferencia.

Por qué necesitamos chips de IA de vanguardia para la IA

Debido a sus características únicas, los chips de IA son decenas o incluso miles de veces más rápidos y eficientes para entrenar e inferir algoritmos de IA que las CPUs. Debido a su mayor eficiencia para los algoritmos de IA, los chips de IA de última generación también son significativamente más rentables que las CPUs de última generación. Un chip de IA mil veces más eficiente que una CPU proporciona una mejora equivalente a 26 años de mejoras en las CPUs impulsadas por la Ley de Moore.

Los sistemas de IA de vanguardia requieren no solo chips específicos de IA, sino también chips de IA de última generación. Los chips de IA más antiguos, con sus transistores más grandes, más lentos y que consumen más energía, incurren en enormes costos de consumo de energía que aumentan rápidamente a niveles inalcanzables. Por lo tanto, utilizar chips de IA más antiguos hoy en día significa costos generales y retrasos al menos un orden de magnitud mayores que los chips de IA de última generación.

Estas dinámicas de costo y velocidad hacen que el desarrollo e implementación de algoritmos de IA de vanguardia sean virtualmente imposibles sin chips de IA de última generación. Incluso con chips de IA de última generación, puede costar decenas de millones de dólares entrenar un algoritmo de IA y llevar semanas completarlo.

Con chips de propósito general, el entrenamiento tomaría considerablemente más tiempo para completarse y costaría magnitudes de órdenes más, lo que haría prácticamente imposible mantenerse en la vanguardia de la investigación y la implementación. De manera similar, la inferencia utilizando chips menos avanzados o menos especializados podría implicar costos excesivos y llevar magnitudes de órdenes más tiempo.

Resumen de las tecnologías relacionadas con los chips de IA

Algunas de las tecnologías y aplicaciones relacionadas con los chips de IA incluyen:

Video/Imagen:

- Reconocimiento facial

- Detección de objetos

- Generación de imágenes

- Análisis de video

- Auditoría de contenido de video

- Mejora de imágenes

- Búsqueda por imagen

- Realidad aumentada

Sonido y voz:

- Reconocimiento de voz

- Síntesis de lenguaje

- Despertar de voz

- Reconocimiento de vozprint

- Generación de música

- Altavoz inteligente

- Navegación inteligente

NLP (Procesamiento de Lenguaje Natural):

- Análisis de texto

- Traducción de idiomas

- Comunicación humano-máquina

- Comprensión de lectura

- Sistemas de recomendación

Control:

- Autopiloto

- Vehículos aéreos no tripulados (UAV)

- Robótica

- Automatización industrial

Topología de redes neuronales:

- Perceptrón multicapa (MLP)

- Redes neuronales convolucionales (CNN)

- Redes neuronales recurrentes (RNN)

- Memoria a largo plazo de corto plazo (LSTM)

- Redes neuronales de impulsos (SNN)

Redes neuronales profundas:

- AlexNet

- ResNet

- VGGNet

- GoogLeNet

Algoritmos de redes neuronales:

- Propagación hacia atrás (Back Propagation)

- Aprendizaje por transferencia (Transfer Learning)

- Aprendizaje por refuerzo (Reinforcement Learning)

- Aprendizaje de una sola vez (One-shot Learning)

- Aprendizaje adversarial (Adversarial Learning)

- Máquina de Turing neuronal (Neural Turing Machine)

- Depresión a largo plazo y potenciación a corto plazo (STDP)

Algoritmos de aprendizaje automático:

- Máquina de vectores de soporte (SVM)

- Vecino más cercano (K-Nearest Neighbor)

- Bayesiano

- Árbol de decisiones

- Cadena de Markov

- Adaboost

- Word Embedding

Optimizaciones de rendimiento de chips:

- Optimización de eficiencia, bajo consumo de energía, alta velocidad, flexibilidad, aplicada a aceleradores de aprendizaje profundo y chips de reconocimiento facial

Chips neuromórficos:

- Computación inspirada en el cerebro

- Estimulación cerebral biológica

- Simulación de mecanismos cerebrales

Chips programables:

- Enfoque en flexibilidad, programabilidad, compatibilidad de algoritmos y compatibilidad de software, como DSP, GPU y FPGA

Arquitectura de sistema en chip:

- Multi-core

- Many-core

- SIMD

- Matriz de unidades aritméticas

- Interfaz de memoria

- Red en chip

- Interconexión multi-chip

- Interfaz de memoria

- Canales de comunicación

- Caché multinivel

Herramientas de desarrollo:

- Interfaz a marcos de trabajo de aprendizaje profundo (Tensorflow, Caffe)

- Compilador

- Simulador

- Optimizador (Cuantización, Poda)

- Operaciones atómicas (Capas de red) Biblioteca

Memoria externa de alta velocidad:

- HBM

- DRAM

- GDDR de alta velocidad

- LPDDR

- STT-MRAM

Interfaz de alta velocidad:

- SerDes

- Comunicación óptica

Dispositivos biónicos (sinapsis artificiales, neuronas artificiales):

- Memristores

Nuevos dispositivos de cómputo:

- Computación analógica

- Computación en memoria (In-memory Computing)

Memoria en chip (matriz sináptica):

- SRAM distribuido

- ReRAM

- PCRAM

Proceso CMOS:

- Nodo de proceso (16, 7, 5 nm)

Apilamiento 3D CMOS:

- IC/SiP de 5D

- Tecnología de apilamiento 3D

- 3D monolítico

Nuevas tecnologías:

- NAND 3D

- Transistores de túnel de flash

- FeFET

- FinFET

En la actualidad, los chips de IA todavía están en una etapa incipiente y existen muchas incertidumbres. Sin embargo, la investigación en torno a los chips de IA está avanzando significativamente en el aprendizaje automático basado en redes neuronales, que se considera superior a la inteligencia humana para resolver problemas intensivos en cómputo. Sin embargo, aún queda un largo camino por recorrer para resolver problemas cognitivos y lograr una inteligencia generalizada (Inteligencia Artificial General, AGI). La capacidad de cómputo y eficiencia energética ideal de AGI debería ser al menos varias órdenes de magnitud mayor que la de los chips de IA actuales.

Si quieres conocer otras notas parecidas a Hardware de ia: chips de última generación para acelerar el desarrollo de aplicaciones puedes visitar la categoría Inteligencia.